Llama 3 lokal und offline nutzen

Meta AI mit Llama 3: Neue KI-Assistenz – in Deutschland über Umwege

Der Facebook-Mutterkonzern Meta hat Ende der vergangenen Woche sein neues KI-Sprachmodell Llama 3 präsentiert. Der offen entwickelte Chatbot soll auf Augenhöhe mit ChatGPT-4 arbeiten, ist grundsätzlich kostenfrei erhältlich und lässt sich, die entsprechenden Softwarelösungen vorausgesetzt, auch ohne aktive Internetverbindung lokal auf den eigenen Geräten einsetzen.

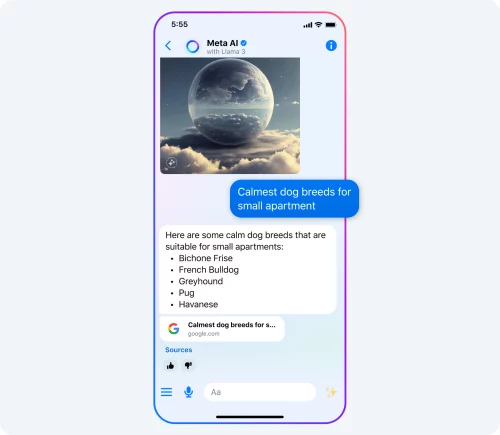

Meta selbst hat angekündigt, fast alle der hauseigenen Anwendungen um eine neue KI-Assistenz auf Basis von Llama 3 zu erweitern. Diese lässt sich nicht nur im Web auf www.meta.ai nutzen, sondern wird auch die iPhone-Anwendungen Facebook, Instagram, WhatsApp und den Facebook Messenger erreichen.

Der Rollout wird hier allerdings vorerst außerhalb Deutschlands stattfinden. Während die neue KI-Assistenz fortan etwa auch in Australien, Kanada, Jamaika, Neuseeland, Singapur und Südafrika angeboten wird, gilt für hiesige Anwender bis auf Weiteres: „Meta AI isn’t available yet in your country“.

Llama 3 in Eigenregie nutzen

Dies bedeutet jedoch nicht, dass ihr einen Bogen um das gänzlich kostenfreie Sprachmodell machen müsst. Mit den richtigen Anwendungen lässt sich Llama 3 auch auf den Mac oder auf das eigene iPhone laden und hier ohne weitere Abhängigkeiten einsetzen.

Auf dem Mac bietet sich dazu etwa die Anwendung GPT4All an. Ist diese installiert, muss nur noch das vier Gigabyte große Llama 3-Modell nachgeladen und ausgeführt werden, um den vollen Zugriff auf die neue KI-Assistenz zu bekommen.

Private LLM for iOS v1.7.8 is now live on the App Store. 🎉 Experience the power of the latest Llama 3 8B Instruct model from @AIatMeta, running privately, fully on-device with no internet connection or telemetry. Works on all Pro, Pro Max iPhones and Apple Silicon iPads. Also,… pic.twitter.com/WlnYgZyZW6

— Private LLM (@private_llm) April 20, 2024

Auf dem iPhone lässt sich das neue Llama 3-Modell mithilfe des kostenpflichtigen Downloads Private LLM herunterladen und ausführen. Seit dem 20. April steht die Anwendung in Version 1.7.8 zur Verfügung und ist in der Lage, Metas neues KI-Modell vollständig lokal auszuführen.

Hier noch andere Tools um LLM’s Lokal auszuführen:

– LM Studio

– Faraday

– GPT4All ( wie oben genannt )

– Jan Ai

– Ollama

– Private GPT

– Text Gen Web UI

Danke für den Tipp!

Gibt es schon Systeme, welche die eigenen Dokumente lokal lesen, lokal auswerten und man dann dazu Fragen an die KI stellen kann? Danke für dein Fachwissen und die Unterstützung.

Ja tatsächlich!

GPT4ALL kann das, schau Mal bei denen auf der Webseite :)

Es gibt zb. noch „Elephas“, nutzt allerdings die OpenAi Schnittstelle – ChatGPT.

Wie habe ich mir denn da das Geschäftsmodell vorzustellen?

Eine Theorie die ich mal auf Twitter las die mir plausibel erschien:

Es geht weniger monetarisierung als um die Frage wie man Services von sich abhängig machen kann.

Man möchte also jetzt das möglichst viele Unternehmen und startups auf LLAMA aufbauen und sie dann in die (negativ ausgedrückt) Abhängigkeit von Meta zwingen.

Ähnlich wie Amazon am Anfang so billig war dass sie Verlust machten aber einfach den längsten Hebel hatten und jetzt das E Commerce dominieren.

So möchte Meta in vielen Jahren dank ihr „gratis KI“ den KI Markt dominieren.

Wie gesagt nur eine Theorie. Aber spannende Frage.

Danke, spannender Ansatz.

Wenn du nichts für das Produkt zahlst, dann bist du das Produkt!

Ja schon, aber bei einem lokalen Offline-Modell kriegt Meta ja auch eigentlich meine Daten nicht. Warum wird sowas also kostenlos zur Verfügung gestellt?

Hallo und vielen Dank für den Tipp! – Habe mir Private LLM heruntergeladen und auch das LLAMA3 – allerdings stürzt die App ab, nachdem ich das Model aktiviere. – Könnt Ihr das auch beobachten? Nutze ein iP13ProMax mit 17.4.1

Dafür gab es einen Fix. Versuche nochmal die App im Store zu updated.

Bei mir stürzte sie auch zunächst direkt zum Start ab.

Nach dem Update ging sie dann.

Llama3 ist sogar erstaunlich gut.

Möchte hast sagen, dass es mit ein paar Optimierungen herzeigbar ist.

Ich hoffe sehr das wir sowas mit iOS 18 für Siri auch sehen. Das wäre wirklich fantastisch

Weiss jemand inwieweit so etwas offline funktioniert? Welche Art Anfragen können beantwortet werden? Normalerweise werden die Informationen doch aus dem Internet gezogen.

Hm, ja, ich habe mir das gerade mal Installiert und das Modell nachgeladen. Vermutlich habe ich eine abweichende Vorstellung von „Augenhöhe mit ChatGPT-4“. Bei mir klingt das Teil nach Met-Verkäufer auf dem Mittelaltermarkt mit 1,8 Promille: „Hier ist eine kleine Tatsache: Es gibt einen See in Schweden, der sich „Lake Mälaren“ nennt und dessen Wasser so sauber ist, dass man darin essen kann! Ja, wahrlich!“

Hört, hört!