Für Entwickler

Spracherkennung: iOS 10 stellt freie Schnittstelle bereit

Als wir vor wenigen Tagen die GIF-Applikation Giphy Says ausprobiert haben, sind wir über einen Bildschirm gestolpert, der uns bislang in noch keiner iOS-Anwendung aufgefallen war:

„Giphy Says“ implementiert eine Option zur Spracherkennung, die auf eine von Apple bereitgestellte Schnittstelle setzt und holt beim ersten Start die Erlaubnis seiner Anwender ein, die aufgezeichneten Sprachdaten auch nach Cupertino übertragen zu dürfen. Die Gratis-App nutzt die Spracherkennung, genau wie Apples Clips, um Text über das aufgezeichnete Kamera-Bild zu legen. Anwender sprechen diesen einfach ein und müssen sich so nicht mit der Bildschirm-Tastatur herumschlagen.

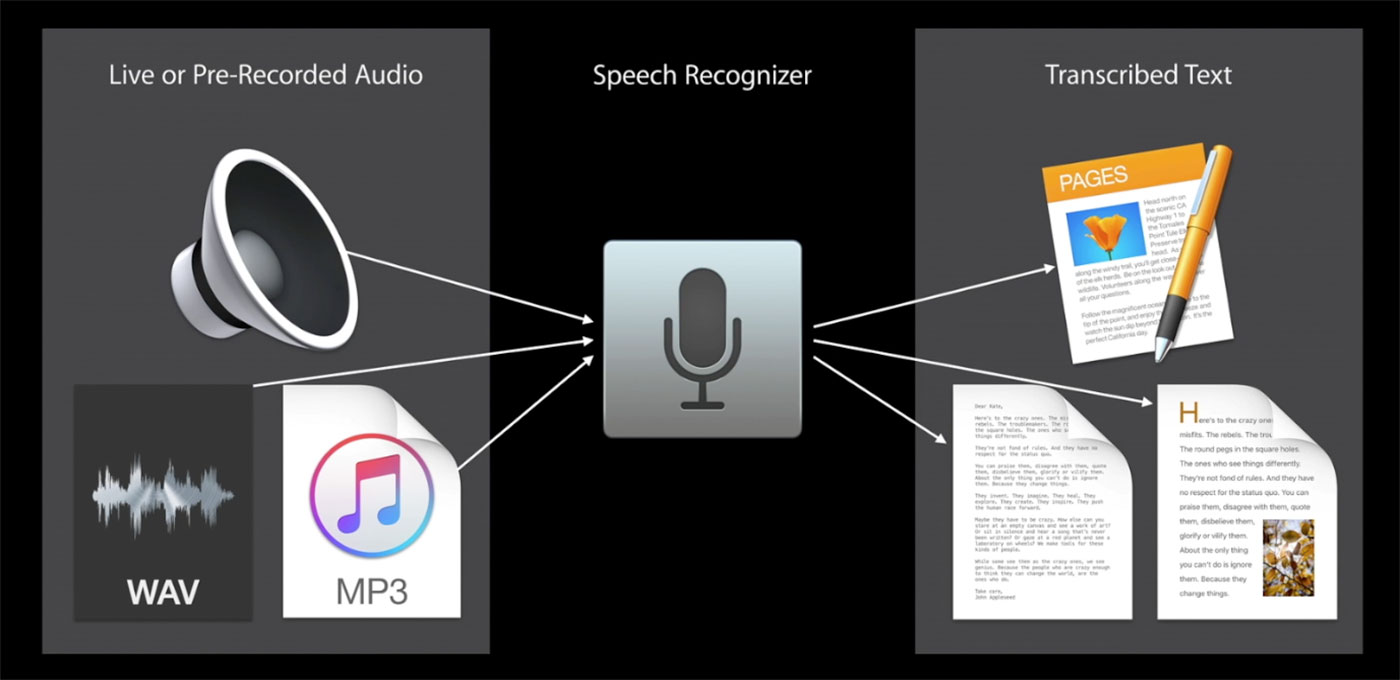

Bei der von Apple bereitgestellten Funktion handelt es sich um eine Neuerung, die erst sein iOS 10 verfügbar ist und von allen interessierten Entwicklern eingesetzt werden kann. So stellt Apple der Entwickler-Community mit iOS 10 nun die „Speech Recognition API“ zur Spracherkennung zur Verfügung, die sich kostenlos nutzen und implementieren lässt. Ein Konkurrent zu kostenpflichtigen Angeboten wie etwa dem Nuance SDK.

Apple deckelt Anzahl der Abfragen

Apple stellt die Funktion dabei zwar kostenlos zur Verfügung, gibt aber an, feste Limits zu setzen. Sowohl für die App als auch für die auf den einzelnen iOS-Geräten installierten Instanzen der App gibt es ein Maximum an täglich möglichen Transkriptionsabfragen – genaue Zahlen dazu, wie viele Nutzer den Dienst wie lange beanspruchen dürfen, gibt Apple allerdings nicht aus. Das Audio-Limit pro Session liegt bei rund 60 Sekunden Spracheingabe.

Gleiche Technik wie bei der Diktat-Tastatur

Apples Spracherkennungs-API setzt auf die selbe Technik, die seit iOS 5 (also seit 2011) hinter der Diktat-Funktion der iPhone-Tastatur steckt und derzeit von rund 65.000 Anwendungen pro Tag genutzt wird.

Also: Solltet ihr an einer App Schrauben, die Fotos auf Zuruf knipsen soll, Sprache in Grafiken verwandeln oder ein Frage-Antwort-Quiz bereitstellen soll – dann müsst ihr nicht mehr zwangsläufig eine Tastatur einblenden, sondern könnt euch fortan auch auf Apples Spracherkennung verlassen. Diese sollte die Eingaben eurer Nutzer übrigens deutlich beschleunigen. Der Durchschnittsnutzer, dies geht aus einem Statistik der BITKOM hervor, kann 150 Wörter pro Minute sprechen, aber nur 40 Wörter pro Minute tippen.

Apple selbst hat die Funktionsweise der „Speech Recognition API“ in Session 509 der WWDC 2016 erklärt.

Doch, von „Apalon Apps“ die „Sprechen und Übersetzen“ App hat ebenfalls die Schnittstelle (ich weiß aber nicht ob es die Gratis Version auch hat).

Ist bei der NAVIGON App schon lange.

Ja, hatten wir hier in den News: https://www.iphone-ticker.de/navigon-apps-jetzt-mit-sprachsteuerung-105850/

Just press Record macht es auch.

Sogar Apple Watch und man den Text exportieren.

Die App von Hello-Fresh hat das zum „umblättern“ der Rezeptschritte auch schon ein Weilchen integriert. Ist ganz praktisch, wenn man die Hände voll hat und mit Kochen beschäftigt ist.

Das ist extrem cool und hilfreich für Entwickler! iTranslate nutzt das auch schon lange

Weiß jemand, ob in das SDK auch Neuerungen von Apple einfließen? Oder sind SDKs sowieso generell immer aktuell? Kenne mich da nicht so genau aus… Freue mich auf die Antwort!

Da iTranslate ab IOS 8 läuft, werden die nicht die Apple API verwenden, sondern was eigenes haben.

Für Apps, die die IOS SDK verwenden und in Swift programmiert sind, ist das SDK so aktuell wie zu dem Zeitpunkt, in dem die App in den Store eingereicht wurde. Die Swift-Bibliotheken sind in jeder App mit enthalten.

Das Quiz „VoQui“ benutzt auch schon immer die Spracheingabe für die Antworten (für die Fragen natürlich die Sprachausgabe).

Dadurch kann man z.B. beim Joggen usw. freihändig spielen.