Beta-Bildeffekte

iPhone 7 Plus: Die Tiefenschärfe-Funktion im Video

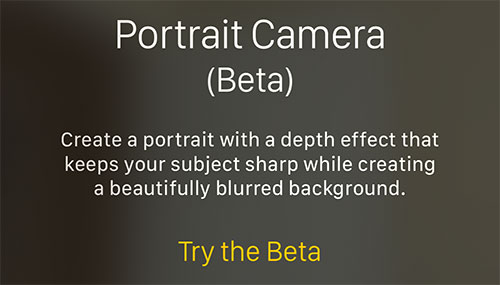

Seit gestern Abend können registrierte Entwickler die erste Beta von iOS 10.1 auf ihren Geräten ausprobieren und damit erstmals auch den sogenannten“Portrait Mode“ auf dem iPhone 7 Plus einsetzen.

Apple hatte die Tiefenschärfe-Funktion im Rahmen der iPhone 7-Präsentation angekündigt, musste die Freigabe der zusätzlichen Kamera-Funktion jedoch verzögern. Zwar begründete Cupertino die nachträgliche Ausgabe des Features damit, dass es sich beim „Portrait Mode“ nur um eine experimentelle Zusatz-Funktion des engagierten Entwickler-Teams handeln würde – die meisten Anwender werden Apple den vertröstenden Spin auf der Bühne aber nicht abgekauft haben. Nicht vergessen: Neben dem schnellen Zoom ist die Tiefenschärfe-Funktion das einzige Feature, das die Kamera des iPhone 7 vom iPhone 7 Plus unterscheidet.

Schwamm drüber. Nachdem die Beta jetzt in den Händen der ersten Tester aufgeschlagen ist – die Freigabe der öffentlichen Testversion dürfte spätestens am Freitag folgen – landen fast stündlich neuen Videos zur Tiefenschärfe-Funktion auf Googles Videoportal Youtube. Einen aktuellen Clip, die Depth Effect Review von iPhonedo legen wir euch dabei gesondert ans Herz.

Der nur 60 Sekunden lange Clip ist zwar nicht ganz so detailliert wie etwa die Bestandsaufnahme von Matthew Panzarino, auf die wir bereits gestern Abend verlinkt haben, zeigt den Einsatz der neuen Foto-Option dafür jedoch am lebenden Objekt und veranschaulicht die Infomeldungen des iPhones, das im „Portrait Mode“ unter anderem über zu kurze Abstände informiert.

Jason Snell liefert einen weiteren Lesetipp zum Thema:

I’m not sure whether Apple is particularly concerned about pleasing people who know how a real depth-of-field blur effect would work, though, or just making an image with a pleasant effect. I’d say this beta is well on the way to doing the latter.

Bei den Haaren unter dem rechten Ohr sieht man, dass es an seine Grenzen stößt.

Es heißt Schärfentiefe !!!

Beruhigen Sie sich bitte.

Beides ist korrekt.

Weshalb immer diese Aufregung? Beide Begriffe bedeuten das gleiche und sind auch gleich richtig.

Schiefentärfe !!

Also hö’ma! Wenn, dann ja wohl Tärfenschiefe. (Tss, Leute gibts…)

Außerdem kommt vor einem Satzzeichen kein Leerzeichen! Desweiteren sind drei Ausrufezeichen quatsch!

„… concerned about pleasing people who know how a real depth-of-field blur effect would work …“

Echte Tiefenunschärfe KANN Apple mit den beiden kleinen Kameras nicht erzeugen. Dafür sind Objektiv und Sensor bei beiden Kameras viel zu nah zusammen. Der Hintergrund wird immer in etwa gleichmäßig unscharf werden, echte Tiefe bekommt man damit schlich nicht hin. Ich finde aber, dass alle Fotos, die ich bisher so gesehen habe, für eine Smartphone Kamera schon ziemlich gut aussehen.

Bokeh ist nicht gleich Bokeh. Die Schärfentiefe überzeugt nicht.

..you see, the background ist blurry.

Trifft es danz gut.

Hab mir heute Testbilder schicken lassen. Sieht in der 100% Ansicht echt nicht gut aus.

Die Ränder sehen aus als hätte ein dreijähriger seine erste Photoshoparbeit abgeliefert.

Wer denkt das kommt nur irgendwie an ein Bokeh von DSLR und Co. heran wird megaentäuscht sein.

Eine Knipse bleibt halt eine Knipse. Ob das alles noch Beta ist oder nicht…..Da gibt’s Apps im AppStore die bekommen das auch ohne 2 Kameras hin.

Der englische Begriff „Depth of Field“/“Depth of Focus“ lautet korrekt übersetzt „Schärfentiefe“ und nicht „Tiefenschärfe“. Dass letzteres synonym benutzt wird, macht es nicht richtiger…

Quarkspeise und Speisequark ist auch nicht dasselbe.

Sprache wird gebildet indem man Sprache bildet.

Je öfter ein Begriff benutzt wird ( von verschiedenen Leuten) desto eher gehört der Begriff zur Sprache.

Selbst im Duden findet man Tiefenschärfe. Ebenso wie Schärfentiefe

Tiefenschärfe ist die korrekte Übersetzung des koranischen Wortes „Saodumm“. Dieser Bergriff wurde früher auch schon mal als Wilson Effekt umschrieben. Da haben die Redakteure schon richtig recherchiert

Ist eigentlich egal wie rum man es übersetzt.

Der englische Begriff ist, für das was dort passiert schon mal grundsätzlich falsch.

Richtig wäre ausmaskieren und unschärfe. Warum man für diese Funktion 2 Kameras benötigt ist völlig unklar.

*gähn* Hatten wir doch schon gestern:

http://scilogs.spektrum.de/spr.....rfentiefe/

Wer sagt das außer Dir?

Und jetzt? ;)

Na, auf einem Techblog sollten die Fachtermini schon korrekt verwendet werden. Ist ja auch nicht das erste Mal, dass ESEL darauf hinweist.

bist du anscheinend immer noch nicht schlauer…schade.

ESEL Rückwärts gelsesen heisst LESE… Und jetzt?

gelsesen Rückwärts gelesen heisst nesesleg….

+1

Aber wenn wir von Unschärfe reden, dann kann ich ja nicht Untiefenschärfe sagen, weil Sich bei Untiefen Abgründe auftun welche durch ihre Schärfe den Schiffsrumpf beschädigen. Soweit ich weis wird Schärfe im allgemeinen in Scoville gemessen.

Richtig kann nicht gesteigert werden. Dass es doch benutzt wird, macht es zu Umgangssprache. Das ist dann wörtlich nicht korrekt, dient aber dem Zweck von Sprache, nämlich zu kommunizieren.

Mir gefällt der effekt leider gar nicht. man sieht, wie das iphone versucht, die kontur des menschens zu erkennen.

Simon sagt es schon ganz gut, es ist ein ganz netter Effekt aber kann so niemals eine SLR ersetzen.

Man kann sehr gut erkennen das das Handy die Person im Fokus quasi ausgeschnitten und dann in den unscharfen Hintergrund eingesetzt hat. Die Haare die vom Wind wehen bzw. abstehen verschwinden da einfach.

Die Funktion ist ja ganz „nett“…aber mich stören mehr die Urteile der Tester zur Qualität der Bilder vom 7er…angesiedelt unter dem 6s.

Chronische Lernresistenz.

Da werden Kameras immer besser und die Leute legen Filter drauf und blurren das Bild damit es wieder so aussieht wie mit einem 12 Jahre alten Nokia Handy geschossen aussieht.

also du hast wohl den sinn der funktion nicht verstanden

es ist eher eine funktion die es aussehrn lässt, wie mit dslr geschossen

Ach, Nokia-Handys von 2004 hatten also 12 Megapixel (ja, ich weiß, das sagt nicht viel aus), Weitwinkel- und Teleobjektiv, optischen Zoom, optische Bildstabilisierung, Panoramabilder, HDR, Serienbilder, 4K Videos, 1080p Videos mit 60 fps, Zeitlupen- und Zeitraffervideos usw.?

Okay.

Ich hole schon mal das Popcorn und lehne mich zurück.

Die haben doch jetzt viel Platz, sollen die doch einen größeren Sensor einbauen und die Naheinstellgränze verringern. Könnte beim Tele ja schon was ausmachen X-)

:-) Bei 56mm kann man tatsächlich schon fast von Portrait-Tele sprechen…

Ehrlich, Leute – ich weiß nicht, was ihr immer habt. Echt super. Verglichen mit der App Tadaa SLR tausendfach besser – auch und vor allen Dingen was die Haare angeht! Und selbstverständlich ersetzt es keine SLR…

Es soll ein nettes Feature sein. Mehr doch nicht.

Leider keinen deut besser als beim HTC M8 vor drei Jahren… Ich hätte schon erwartet, dass man da etwas mehr raus holt, statt einfach „später“

Ich (Vollformat Besitzer) muss sagen. Hut ab. Das ist zwar keine Vollformat und auch die feinen Haare werden da gleich mit in den Hintergrund geschickt. Aber dennoch. Generation Snapchat wird damit gross werden. Ich muss zugeben ich bin beeindruckt. Für jeden nicht Vollformat Besitzer würde das ca. 1h Nachbearbeitung kosten plus das Programm.

Ich kenne Leute die haben keine Lust, keine Zeit, keinen Rechner, kein Programm und auch keine Vollformat. Das einzige was sie besitzen ist ein Handy und ein Familienleben mit 3 Kindern und Haustieren… Und das will festgehalten werden.

Ich… wir… teilweise Technik Nerds und Experten auf speziellem Gebiet… wir werden immer bessere Wege finden für solche Fotos. Aber aber das leben findet halt nicht als postproduktion am PC statt sondern vor der Linse. Für die Leute ist das was man da „nebenbei“ im Handy bekommt einfach Spitze. Und ich hab eine Vollformat für 3000,- die nicht mal Zoomen kann. Heisst ich weiss was gute Bilder sind. Aber mein Fokus liegt ja auch darin bunte Bilder um 0Uhr Nachts zu machen. Und da kommt kein Handy mit. Aber sonst. Hätte ich gerne im iPhone SE Nachfolger.

Ich sage DSLR ist eh tot… Nicht die Vollformat, sondern nur der Spiegel in Ihr… Ich weiss es aus erster Hand das man ohne besser dran ist. Viel viel kleiner.

Endlich mal ein vernünftiger Kommentar. Die beste Kamera ist die, die man immer dabei hat. Das ist nun mal das iPhone und Co. Zu den Spiegellosen… richtig, die werden immer kleiner und handlicher. Aber… Das Glas leider nicht. Die 2.8 oder sagen wir 1.2, 1.4, 1.8er können physikalische nicht verkleinert werden. Was bringt mir eine kleine Kamera, wenn ich eine Blende zwischen 1.2 und 2.0 nutzen möchte und trotzdem die großen Objektive brauche. Aber das nur nebenbei. Ist ein endloses Thema. Ansonsten zurück zum Artikel. Mir gefällt es für mal eben schon ganz gut.

Haben es nach der 10 maligen Erwähnung und dem Vollformatgeprolle geschnallt.

Nur kann das mit dem Bokeh wohl jeder Kamera besser. Entweder durch Erhöhung der Kombination Brennweite-Motivabstand-Hintergrund oder und/oder durch öffnen der Blende.

Aber genau darum geht es ja nicht. Natürlich kann das fast jede Kompakte aufwärts besser. Es geht aber um das Gerät das so oder so fast jeder in seiner Tasche hat und die Kamera zuhause. Ich finde die Richtung schon sehr gut. In Zukunft wird das mit Sicherheit auch besser. DIE Kamera für jede Situation und Art, gibt es eh nicht! Und ob nun Vollformat, DX, MFT, Mittelformat oder was auch immer… das Bild ist am Ende entscheidend. Nur die wenigsten fragen sich dann… mit welchem Equipment wurde dieses nun gemacht. Also. Apple, der Weg ist der richtige!

Sry für mich als “ wenig Foto Schiesser“ und mit wenig Kenntnis. Was soll das denn bringen wenn man Hintergrund verschwommen einen Foto schiesst?

Naja, das sieht im Normalfall schon wesentlich ansprechender aus wenn das Hauptobjekt „freigestellt“ ist.

Das Problem ist das solch ein Bokeh (die Unschärfe im Raum) einen fließenden Übergang hat (von scharf in der Schärfeebene, meist die Augenpartie bei einem Portrait, bis ganz unscharf an der enferntesten Stelle im Hintergund und auch im Vordergrund).

Das iPhone sucht einfach das Motiv und macht alles andere gleichmässig unscharf. Und am Übergang noch recht unsauber….

Bin auch der Meinung: Für solche Photos ist ein Smartphone rein physikalisch nicht geeignet und man sollte es deswegen lassen… Die Dinger knipsen doch wunderbare Fotos heutzutage, warum unbedingt noch den speziellen Funktionen einer DSLR nacheifern?

Genau das macht aber das iPhone auch. Das kannst du im Text verlinkten Artikel nachlesen:

„Note how the tree is less blurry than the background, but more blurry than the subject. This is the depth effect gradient at work. It’s not just blurry or sharp — there is a scale at work that makes it feel more natural.“

@Holger: exakt! Alles, was du geschrieben hast.

Lustigerweise kenne ich eine ganze Menge Leute, die eine geringe Schärfentiefe überhaupt nicht gut finden! Ich fotografiere mit verschiedenen Kamera- und Objektivkombinationen (DSLR und spiegellos) und setzte diesen Effekt gerne ein, aber ich höre durchaus auch mal: Wieso ist das alles so unscharf? :-D

Ich finde das ganze Bild wirkt mit Filter unscharf

Stimmt, jetzt fällt es mir auch auf. Sieht man recht deutlich in den Haaren oder auf der Haut.

Genialer Schachzug von Apple es nicht sofort zu zulassen, so wird erst richtig Interesse geweckt!

LOL die Haare von dem Kind werden auch unscharf.

Warum regt ihr „Hobby-“ oder „Profi-“ Fotografen denn so auf? Habt ihr angst, dass euch jemand was wegnimmt?

Ich finde den Effekt klasse und werde ihn sicher auch ab und zu verwenden. Meine iPhone Kamera ist nun mal die einzige die ich immer bereit habe.

*euch

Ich bin Fotograf und finde den Effekt nett. Warum sich hier jetzt die Mehrheit über die vermeintlich schlechte Umsetzung von Apple aufregt, kann ich nicht nachvollziehen.

Mal ehrlich, Smartphone-Fotos guckt man sich meist auf nem Smartphone an – da kommt es nicht auf ein paar aus versehen unscharfe Haare auf nem Kinderkopf an …

Danke! Du scheinst es verstanden zu haben :)

Richtig! Und das Freistellen in Photoshop ist auch keine sooo angenehme Arbeit :-)

^wenn man es gut machen will!^

Bei dem ganzen Gestreite hier um Tiefenschärfe und Schärfentiefe wird ganz vergessen über das Feature an sich zu meckern :D

Habe es jetzt mal ausprobiert und habe auch eine DSLR zuhause also weiß ich zumindest ein wenig darüber Bescheid.

Vergleichen lässt es sich wirklich kaum. Es sieht aus wie schlecht reingeschnitten. alles im Vordergrund verschwimmt erst gar nicht und die Bedingungen um den Effekt zu erzeugen sind zu viele als dass es auch nur annähernd vergleichbar wäre.

Jetzt kommt das große ABER…

das hat Apple auch nicht gesagt. Ich denke für die Snapchater und Instagramer und Facebooker ist es ein nettes Gimmick dass einige Portraitfotos noch aufhübscht. Da niemals jemand immer seine DSLR dabei hat ist dass wohl das beste was man an „Bokeh“ bekommen kann für ein gerät dass man definitiv immer dabei hat.

Ich finde das Feature hat meine Erwartungen ein wenig untertroffen allerdings ist es nicht so schli9mm wie es hier dargestellt wird.

Der Effekt befindet sich in der Beta Phase. Vlt ist das finale Ergebnis besser!

ich kann mir ehrlich gesagt nicht vorstellen dass es überhaupt software-technisch viel besser geht. außer man würde vielleicht die unschäre schon einen my auf dem objekt beginnen dann würde es vielleicht nicht mehr so abgehakt aussehen. wir lassen uns überraschen.

@Ben Te: Ich glaube fest daran, dass es noch besser wird. Darum gibt Apple die Beta frei. Ich kann mir gut vorstellen, dass Apple jetzt mal die Leute damit rumspielen lässt und jetzt auf dem Internet die entsprechenden Bilder in den Artikeln und Videos zusammensucht um zu sehen, wie das Bild aussieht je nach Situation und so Verbesserungen anbringen können. Und sorry, wenn Apple dieses Feature mit so viel Brimborium ankündigt muss es eindeutig besser sein, als es jetzt ist.

Es erinnert eher an Tilt-Shift per Software als an Tiefenschärfe / Schärfentiefe

Ein Standart Portrait Objektiv liegt bei 85mm f1.2 – f2.0 auf Vollformat kleinbild. Ein Teleportrait liegt bei 135 – 200 mm

Umgerechnet auf kleinbild haben die 1/3 Zoll Sensoren (die Tele Linse 1/3,6 Zoll) also einen Cropfaktor von 8,1

Daraus ergibt sich bei der Weitwinkelobjektive eine reale Brennweiter von 3mm und bei der portraitlinse von 5,8mm (Sensor 20% kleiner)

Hätte das iPhone ne 56mm linse wäre es ziemlich dick. Um genau zu sein wäre es mindestens 7 Zentimeter dick :DD

Also ich finde die Tiefenschärfe nicht einmal so schlecht ,und man muss sich im Klaren sein es ist ein Handy und keine DSLR Kamera.

Ist doch toll wenn man beim Fotografieren noch ein paar Optionen mehr hat sprich Tiefenschärfe,und durchs experimentieren mit der Funktion können doch richtig tolle Bilder entstehen.

Und richtig wenn das Bild mal im Kasten ist (Handy) fragt kein Mensch nach wie es entstanden ist.