Kinderschutz-Offensive erntet auch Kritik

Dickpic per iMessage: iOS 15 warnt vor Penis-Bildern

Während wir uns am Donnerstagnachmittag noch auf gut unterrichtete Quellen berufen mussten, hat Apple die hauseigene Offensive gegen die sexuelle Ausbeutung von Kindern inzwischen ganz offiziell bestätigt: iOS 15 wird mehrere Neurungen einführen, die Kinder und Heranwachsende schützen und die Verbreitung von kinderpornographischen Inhalten unterbinden sollen.

Kinderschutz-Offensive erntet auch Kritik

Unter anderem wird Apple dazu übergehen lokale Foto-Inhalte mit einer Datenbank bekannter kinderpornographischer Motive abzugleichen, noch bevor diese ihren Weg vom iPhone in Apples iCloud antreten. Ein Vorstoß, der vor allem in der Community der Datenschützer und Sicherheitsexperten für kritische Reaktionen gesorgt hat.

Der Vorwurf: Apple würde ein Filter-System integrieren, das trotz Ende-zu-Ende-Verschlüsselung in der Lage sei, den vorhandenen Content auf nicht gewünschte Inhalte zu prüfen. Was jetzt gegen die Verbreitung von kinderpornographischen Inhalten gedacht sei, könnte langfristig von autoritären Regimen genutzt werden, um regierungskritische Inhalte aufzuspüren.

iOS 15 warnt vor Penis-Bildern

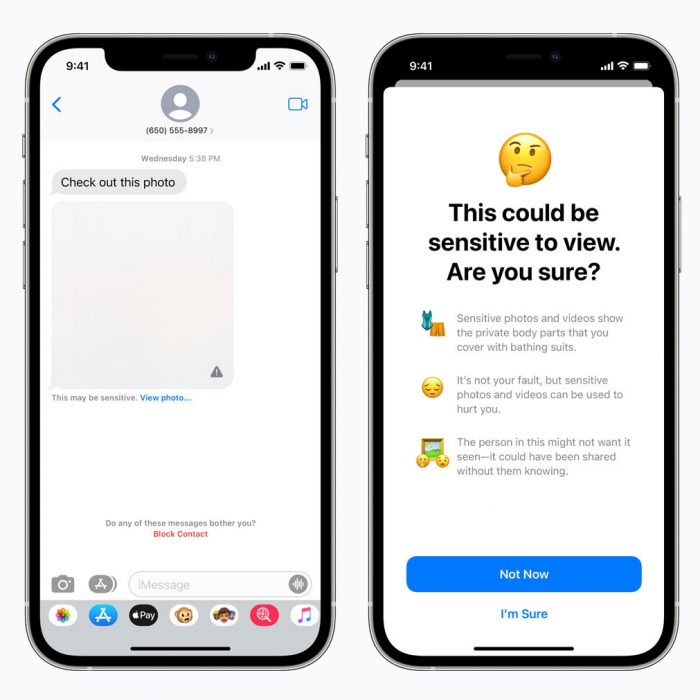

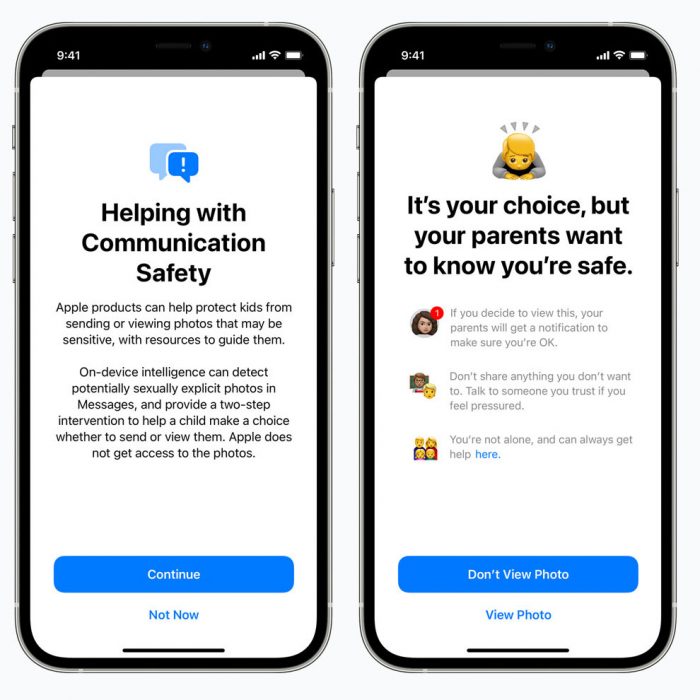

Neben dem lokalen Scan von Medieninhalten, mit dem Ziel kinderpornographische Treffer an die entsprechenden Stellen zu melden, hat Apple auch vor die über iMessage verschickten Bilder auf sexuell eindeutige Inhalte zu prüfen. Werden entsprechende Motive in laufenden Konversationen gefunden, warnt iMessage unter iOS 15 den Benutzer und verlangt zur Anzeige der Inhalte eine gesonderte Bestätigung. Wird diese Erteilt, werden auch die Eltern der eigerichteten Familienfreigabe informiert.

Die Erkennung der sexuell eindeutigen Inhalte soll laut Apple ausschließlich auf dem iPhone vorgenommen werden und baut keine Verbindungen zu entfernten Servern auf. Bei Treffern informieren zusätzliche Info-Hinweise die Kinder vor möglichen Gefahren und Implikationen, sollte sich für die Anzeige des Bildes entschieden werden.

Was passiert denn, wenn auf einem Gerät entsprechendes Material gefunden wird? Wird die Polizei benachrichtigt?

Apple wird Treffer an das National Center for Missing and Exploited Children (NCMEC [0]) melden.

[0] https://www.missingkids.org/HOME

Was hat das NCMEC mit der Verfolgung von bekannten Abbildungen von Kindesmissbrauch zu tun? Quelle?

Da bin ich gespannt, wie sie die Meldung an eine US-amerikanische Institution mit europäischen Datenschutzbestimmungen in Einklang bringen wollen.

Ja das scheint ja das Problem zu sein. Das wird ja spannend bei falschem Alarm…

Es gibt kein falschen Alarm. Da mit vorhanden Material verglichen wird in deren Datenbank.

Theft, natürlich kann es eine Hash Kollision geben

Bei der Hash-Länge eher unwahrscheinlich

Unwahrscheinlich heißt nicht unmöglich.

Peter, bei falschem Alarm hoffe ich sehr auf eine adäquate Reaktion der STAnwaltschaften zulasten von Apple, wegen Tatbeständen wie „Datenausspähung“ usw. .

Gepaart mit harschen Geld- und Gefängnisstrafen ohne Bewährung für die Verantwortlichen.

Zugunsten des (allgemeinen) Datenschutzes. Kinderpornographie ist widerlich. Dennoch: der Zweck heiligt eben nicht (immer) die Mittel, und schon gar nicht, wenn ohne Gerichtsbeschluß auf Verdacht global in Privatphotos geforscht werden soll – Kriminalisierung von Kreti und Pleti inbegriffen.

Im Apfel ist der Wurm, läuft gegen alle Sturm … :-<<

Die Eltern der Kinder werden benachrichtigt. Steht im Text.

Nee, im Text steht, dass die Eltern benachrichtigt werden, wenn ihr Kind dem Empfang eines solchen Bildes zugestimmt hat (sofern der Kinder-Account über die Familienfreigabe eingerichtet ist)

Die Frage zielte aber darauf ab, was passiert, wenn die KI in der eigenen Foto-Bibliothek ein solches Bild identifiziert.

Es gibt keine KI die in der Fotobibliothek nach derartigen Fotos sucht.

Doch tut es ja gerade doch. Diese ist aber wohl nur aktiv, wenn iCloud Photos eingeschaltet ist (auch wenn schon vor Upload in die cloud gescannt wird). Jedes Bild hat einen „einzigartigen“ Fingerabdruck und Apple gleicht alle Fingerabdrücke der Bilder in deiner iCloud mit den Fingerabdrücken von bekannten kinderpornografischen Bildern ab. Bei einem positiven Match werden entsprechend die oben genannten Behörden informiert.

Dies wird auch heftig von Datenschützern kritisiert, wie oben im Text auch beschrieben.

Die iPhones haben einen MachineLearning-Kern auf dem Axy.

Der durchforstet lokal angelegte Fotos und kann unter anderem Gesichter und Gegenstände erkennen. Such mal in der Foto App nach „Auto“ oder „Pferd“. Die könnte, wenn sie entsprechend trainiert wurde , auch „Dicks“ finden.

Was ist ein Axy? Nie gehört und Google kennt es auch nicht.

Axy mit x=0 oder 1 und y=[0;9]

Gemeint sind die A-Prozessoren mit fortlaufender Nummer

Wieso sollte sie? Es geht um gesendete Bilder

Dein Kommentar lässt viel spiel für falsch Interpretation…

Jenachdem, was man interpretieren/unterstellen möchte^^

Gerade in der Frage falsch-positive Treffer sollte das für jeden relevant sein.

Während das im Kontext von Contentfiltern bei YouTube vielleicht nur nervig ist, kann das hier bei falscher Beschuldigung schon ganz andere Auswirkungen haben.

Auf deine unterschwellige Andeutung gehe ich jetzt mal gar nicht ein. Mich hat es nur interessiert, weil ich bisher noch nichts darüber gelesen habe.

Nee. Lediglich Edathi

Die Verpflichtung, Kommunikation auf „Kinderpornografie“ zu scannen, ist doch auch gerade entgegen aller Bedenken u.a. in der EU durchgedrückt worden, oder?

Apple oder Google, die müssen sich also überlegen, wie sie das machen.

Variante a: Nach dem Upload auf ihre Servern. Dann müssen die Daten in der Cloud unverschlüsselt (bzw. nicht nennenswert verschlüsselt) gespeichert werden.

Valiante b: Vor dem Upload auf ihre Server. Also auf dem Device. Dann können die Daten in der Cloud so gespeichert werden, dass sie Apple/Google nicht lesen können.

Von der Architektur her ist Apples Lösung für die Umsetzung der Anforderung die richtige.

Politisch ist das Kind wohl in den Brunnen gefallen, die Scanpflicht kommt, das ist nicht Apples Fehler. Ich habe allerdings wenig Empörung darüber gesehen.

Ihr habt ja sicher alle bei der Bürgerbefragung der EU letztens mitgemacht, oder?

Die Verpflichtung, Kommunikation auf „Kinderpornografie“ zu scannen, ist doch auch gerade entgegen aller Bedenken u.a. in der EU durchgedrückt worden, oder?

Apple oder Google, die müssen sich also überlegen, wie sie das machen.

Variante a: Nach dem Upload auf ihre Servern. Dann müssen die Daten in der Cloud unverschlüsselt (bzw. nicht nennenswert verschlüsselt) gespeichert werden.

Valiante b: Vor dem Upload auf ihre Server. Also auf dem Device. Dann können die Daten in der Cloud so gespeichert werden, dass sie Apple/Google nicht lesen können.

Von der Architektur her ist Apples Lösung für die Umsetzung der Anforderung die richtige.

Politisch ist das Kind wohl in den Brunnen gefallen, die Scanpflicht kommt, das ist nicht Apples Fehler. Ich habe allerdings wenig Empörung darüber gesehen.

Ihr habt ja sicher alle bei der Bürgerbefragung der EU letztens mitgemacht, oder?

@Peter und @Frank: 2 x unter verschiedenen Namen?

Für Snapchat oder Insta-DMs wäre ja sowas praktisch. Aber für

iMessage? Wenn man jemanden seine iMessage-Nummer weitergibt, will man auch Nachrichten von dieser Person bekommen…

Oder ein Bekannter hat die Nummer bei Facebook hochgeladen, so das selbst die Spambots die Nummer haben.

Ich bin auf die Fehlerquote gespannt. Ist das Baby auf dem Wickeltisch oder auf Mamas Bauch nach Apple Prüfung dann pornografischer Inhalt? Und was macht Apple dann? Polizei benachrichtigen? Konto sperren? Gerät sperren? Nicht falsch verstehen, ich finde den Ansatz durchaus wichtig und lobenswert. Nur solange unbekannt ist was und wie Apple da prüft habe ich Bedenken.

Warum muss das Baby auf dem Wickeltisch nackt fotografiert werden? Kann man das – auch unter dem Gedanken, was andere mit solchem Bildmaterial anstellen – nicht einfach sein lassen?

Und warum sollten das Eltern nicht tun? Vielleicht möchte Mama einfach festhalten wie Papa sich beim ersten Wickeln angestellt hat und sich eine Erinnerung schaffen wo man bei dem Bild sagen kann : Weißt du noch vor 5 Jahren wie blöd du dich da beim ersten Mal angestellt hast?

Ich finde das total Ligitim.

Oder wen der kleine im Sommer nackt im Planschbecken sitzt weil das für Kinder normal ist !

Nur weil du das nicht für wichtig und richtig erachtest ist es noch lange kein gesellschaftlicher Standort oder Verpflichtung

da muss ich leider widersprechen @CoCO3. Ich bin selbst „Eltern“

Nein solltet man nicht. Alles ab unter Bauch sollte nicht auf Fotos. Man kann ja so fotographieren, dass man die Windel davor hat – oder eine andere Perspektive wählen die was verbirgt. Gleiche beim Baden, entweder sein lassen oder eher seitlich bzw. wenn das Kind im Wasser sitzt. Ich will ja auch nicht, dass mein nackter Arsch auf Fotos ist – genauso haben Kinder auch ein Recht auf Privatsphäre.

PS: Man muss nicht alles im Bild festhalten, vor allem nix peinliches oder anrüchiges – vielleicht lieber am Moment erfreuen.

Vielleicht ist aber auch nicht jeder so prüde und für manchen Nacktheit einfach normal.

Ich habe noch keine Kinder aber Kinderbilder von mir nackt existieren. Sowohl auf dem Wickeltisch, als auch am Strand und sogar an Weihnachten weil das für uns ein Spaß war nackt um den Christbaum rumzulaufen.

ich hätte kein Problem damit auch meine Kinder in den Situationen zu fotografieren, das sind einfach schöne Erinnerungen.

1+ richtig

Da muss ich leider auch widersprechen. Bin auch „Eltern“ uns+d sehe das anders…

In der Welt heute verstehen Menschen so etwas nicht. Früher hat man die Bilder analog geschossen und in ein Album gegenlenkt was normal war.

Ja man muss Kinderschaender und Vergewaltiger bestrafen, nur ist das meiner Hinsicht nach die Aufgabe der Justiz und die ist viel zu gutmütig in diesem Land. Und Apple hat in meiner Privatsphäre nichts zu suchen !

+1

Ich kenne viele Eltern die auch schon in analogen Zeiten ihre Kidds nackt fotografiert haben zb im Schwimmbad oder wenn der/die kleine mal wieder nackig durch die Wohnung turnen und irgend einen Mist anstellen.

Leute lasst die Kirche im Dorf, solche fast 50 Jahre alten Fotos gibt es von mir auch.

Ich empfinde das Ökosystem und die Bevormundung langsam echt heftig.

Es geht sie nichts an, ob und wie Eltern ihr Kind auf dem Wickeltisch ablichten.

Und Apple geht’s sowieso nichts an.

Man sollte beim Foto zudem dem Baby einen schwarzen Balken auf die Augen legen, damit es später nicht wegen Verletzung der DSGVO klagt. Liebe Zeit…in welcher Zeit bin ich nur angekommen?

Hier geht es um die Veröffentlichung dieser Fotos. Früher wurden sie nur in ein Album geklebt und den Angehörigen und evtl. Freunden gezeigt. Jetzt sieht sie die ganze Welt und die Kinderschänder freuen sich darüber, wie dumm die Eltern sind. Viele dieser Bilder finden dann auch noch den Weg in eindeutige kinderpornografische Webseiten und Netzwerke.

Es werden nicht Bilder gemeldet die man selbst gemacht hat, sondern Bilder mit Pornografieschen BEKANNTEN Bildern verglichen. Erst wenn es da eine Übereinstimmung gibt, wird es gemeldet. Es wird nicht verhindert das neue Bilder erkannt werden, sondern das bekannte Bilder nicht weitergesendet werden…

Noch…

Ich bin sicher das sich hier für Apple und Behörden (das gehört ja schon fast zusammen) ungeahnte Möglichkeiten auftun.

Die Art-Prüfung bzgl. False-Positive-Meldung ist ja nur dann wichtig wenn man weiß wie die Handlungen danach aussehen.

Was wenn eine false-positiv-Meldung in Deutschland gemacht wird? Rückt sofort das SEK-Team raus und stürmt meine Wohnung oder wird freundlich nachgefragt? Bzw. Wird überhaupt irgendwas getan? So überzeugt bin ich von den deutschen Behörden diesbezüglich noch nicht wirklich.

Und wenn man die (aktuellen) Nachrichten verfolgt sollten solche (Mit)Täter und die solches verbreiten gefasst und bestraft werden. Und das ist nur milde ausgedrückt.

Der Abgleich mit bekannten Bildern ist aus meiner Sicht nur der erste Schritt. Ein weiterer wäre eine „schlaue ai“ selbstständig suchen zu lassen um auch „neue“ Bilder zu finden. Bestimmt nicht gleich morgen aber in ein paar Jahren bestimmt.

Siri versteht mich heute noch nicht richtig wenn ich am homepod eine Song hören will. Ich wäre da mal ganz vorsichtig AI oder KI einzusetzen um sowas zu filtern…..

Was schon gruselig ist wo Apple Fotos Katzen erkennt wo ich teilweise Probleme hätte Sie zu erkennen bzw. es auch ein Hund sein könnte wenn nur Fell zu sehen ist …

Die automatische Erkennung gibt es ja bei Fotos schon. Man kann nach Motiven suchen, und das funktioniert oft ganz gut.

Für Erwachsene muss das natürlich komplett abzuschalten sein, aber für Heranwachsende finde ich den Gedanken durchaus erforschenwert

Aber wie soll das funktionieren? Eltern werden eine ganze Menge von Kinderfotos auf ihren Handys haben. Verdächtig wäre es meiner Meinung nach dann, wenn jemand sehr viele Fotos von vielen verschiedenen Kindern auf dem Gerät hortet.

Das kann aber auch grundsätzlich erstmal auf Erzieher:innen zutreffen

Die das nicht dürfen, da Datenschutz und DSVGO Vorgaben. Hier wird bei jeder Aktion von den Eltern erwartet dieses abzunicken und Fotos mit dem privaten Handy zu schießen ist komplett untersagt. Dafür gibt es eine offizielle Kamera für die KiTa die auch unter Verschluß ist.

@Thorsten

Ich bin Tagesvater und habe die Erlaubnis aller Eltern die Kinder zu fotografieren. Von daher habe ich jede Menge Kinderfotos (natürlich bekleidet) auf meinem Handy. Also völlig DSGVo konform. Damit mache ich Erinnerungsfotobücher. Warum sollte man auf solche schönen Bilder verzichten? Sollte ich für ein Kind keine Erlaubnis haben würde ich es schwärzen und es könnte dann natürlich auch kein Fotobuch bekommen. Bisher haben alle Eltern mit Freuden zugestimmt. Ich finde, der Umgang mit Verboten und Vorschriften (Gendersprache) wird immer verkrampfter und nimmt einem den Spaß an vielem. Die wenigsten wollen Gendersprache, sie wird nur von einigen Berufsempörten durchgesetzt. Die wenigsten sehen jedes Kinderbild als Kinderporno, aber alle sollen sich einschränken. Auch auf unseren Festen dürfen selbstverständlich alle Eltern Fotos von allem machen. Damit sind alle einverstanden.

Selbst in unserem Kindergarten ist man inzwischen wieder etwas lockerer geworden und an den Garderoben dürfen wieder Kinderbilder aufgehängt werden. Zwischenzeitlich war es mal untersagt. Da fehlt aber dann doch etwas. Es ist so ein Generalverdacht. Als Tagesvater kenne ich das. Durch die mediale Berichterstattung könnte man glauben, halb DE besteht nur noch aus Pädophilen. Sollte aber einer erwischt werden (auch bei Vergewaltigern) sollte auch härter bestraft werden + Sicherheitsverwahrung und ohne die Möglichkeit von einem Psychologen freigetestet zu werden. Die einzige Möglichkeit frei zu kommen sollte eine irreversible Kastration sein. Es gibt zu viele Rückfälle.

Es geht niemanden etwas an, wie Eltern ihre Kinder fotografieren! Kindesmissbrauch natürlich ausgeschlossen! Wenn mal ein Kind nackt fotografiert wird geht es doch eher um die Situation als um das nackte Kind. Mir fehlt da aber auch die Fantasie, was an einem nackten Kind erregend sein könnte.

Kinderbilder auf einem fremden Handy finde ich nicht gut. Auch wenn es der Erzieher des Vertrauens ist. Zu schnell sind diese Bilder im Internet wenn jemand das „private“ Handy in der Hand hat. Für mich ist es wichtig, dass man Beruf und Privates trennt. Und ich bin kein DSVGO Korrinthenspinner, Bilder der Kinder am Kleiderhaken halte ich für absolut okay wie auf einer Posterwand oder einen Geschenk für den/die Erzieher*in. …nur auf einem privaten Handy außerhalb der Kontrolle einer Regelung ist ein No-Go für mich.

Das mit der Situation ist absolut korrekt. Ein privates Bild von meinem Kind im eigenen Pool ist was anderes als ein Bild in eindeutiger Pose im WhatsApp Verteiler … da müssen hier einige begreifen, dass da ein himmelweiter Unterschied ist.

(Zumindest derzeit) werden keine Bilder gescannt, sondern nur der Fingerabdruck deiner Bilder mit denen von bekannten kinderpornografischen Bildern verglichen. Deine privaten Bilder werden also (noch) nicht angeschaut und geguckt, was drauf ist.

Hier geht es um zweierlei. Einerseits die Prüfung auf Kinderpornografische Inhalte, und die Warnung vor Bildern mit sexuellem Inhalt. Letztere ist ja eher unkritisch, da man solche Fotos ja auch völlig legitim austauschen kann und darf, wenn man darauf steht.

+1 Im Prinzip wird es lokal ausgewertet und die Anzeige verhindert. Wenn das Bild ein bekanntest ist aus der Szene wird es gemeldet.

Sehe ich eher kritisch !

Ich auch, das ist die Büchse der Pandora.

Wird nicht lange dauern bis z.B. China verlangt , dass auch anderer Content zu suchen/filtern ist. Und Apple wird sich dem beugen (lokale Gesetzgebung)

Brave new world

Oh du hast 15 winnie pooh bilder auf dem iphone? GULLAG!

Das Problem ist einfach wo man die Grenze zieht

Apple hat sich da auf Abwege begeben. Die Gadgets der Nutzer ungefragt zu durchleuchten, das hat nichts mit angegebenen Ziel zu tun. Das ist auch nicht Aufgabe Apples Richter oder Polizei zu spielen.

Eine Meldung wird nur versendet wenn du bekannte Bilder auf dem Gerät hast. Es passiert lokal auf dein Gerät.

Es wurde von der EU beschlossen. Apple ist der erste mit einer konkreten Umsetzung. Google, Facebook, Amazon und co. werden folgen

Junge das ist eine EU Verordnung. EU Chat Kontrolle

Kontext wäre für diese Nachricht wichtig gewesen. Microsoft macht das schon lange und ist maßgeblich an dem Programm beteiligt bzw. hat es mit begründet. Wenn Apple sich nicht freiwillig fügt, dann wird das iPhone das „Telefon der Pädophilen“. Ich bin mir sicher, dass sie diesen Stempel vermeiden wollen. Wäre auch ein gefundenes Fressen für die Konkurrenz.

Ich mag solche Maßnahmen nicht. Pädophilie ist der Terrorismus des kleinen Mannes. Darüber kann alles legitimiert werden. Nichts umsonst ist der populärste Slogan der NPD „Todesstrafe für Kinderschänder“ – da können sich leider viele Menschen mit identifizieren und es ist schwer zu rechtfertigen, warum das ein irrer Slogan ist, da man sich ja praktisch für Kinderschänder ausspricht, wenn man dagegen ist.

Und obere Kommentare haben es schon eindrucksvoll bewiesen: bei Skepsis schwingt eine gewisse Unterstellung mit. Nochmal: Das ist auch das Argument in den USA für diesen laxen Umgang mit Daten. „Wer nichts zu verbergen hat, hat auch nichts zu befürchten.“. Privatsphäre ist ein Grundrecht – nichts, was man sich irgendwie verdienen oder wofür man sich rechtfertigen müsste.

@Thomas: 100% Zustimmung.

Das Problem dabei ist nicht die „Beteiligung“, sondern dass das jetzt schon auf dem Gerät direkt läuft und nicht bei hochgeladenen Bildern.

Dabei steht das im Kontext zur Moral der USA bzw. anderer Länder.

Bilder verlassen hier nicht den „Privatraum“ (um z.B. auf einem nicht-privaten Server geladen zu werden) sondern werden lokal verarbeitet. Abgesehen vom „Was kostet das an Akkuleistung?“ stellt sich mir die Auswirkung der ethnografischen moralische Gesinnung in den Vordergrund.

Erst sind es primäre und sekundäre Geschlechtsorgane, dann sind es Füße, wenn Menschen zu 80% unbedeckt sind (z.B. Strandfotos) sowie persönliche Aufnahmen von FKK Bereichen (die in anderen Ländern verpönt sind, in anderen legal und gut genutzt) und wenn dann in einem arabischen Land eine Frau gesteinigt wird, weil sie ein Foto ihres Fußknöchels, des Gesichts, Haares oder einer Hand fotografiert hat (je nach Auslegung) oder man durch erweitere Analysen ihr einen Ehebruch vorwerfen möchte dann wird es kritisch.

Ich finde, Dinge die auf meinem Gerät sind haben dort unangetastet zu bleiben. Wenn meine Tochter solche Bilder „bekommt“, dann haben sie bereits einen Server durchlaufen, da ist es gut, wenn ich informiert werde. Bei selbstgeschossenen Bildern dagegen, da sollen die mir fern bleiben. Die Benachrichtigung allerdings tritt nur dann ein, wenn die Person als „Kind“ betitelt ist. Das ist bei Apple bis einschließlich 14 Jahren der Fall. Wann bekommen die meisten Kinder ihr Smartphone?

Hier wird mal wieder bunt gemischt. Warum lese und VERSTEHE ich eine Meldung nicht erst mal, bevor ich hier kommentiere.

Da werden wieder lustig SEKs nach Hause geschickt, wenn Eltern Ihre Kinder in der Badewanne ablichten…Wasn QUATSCH!

1) Das einzige, was an die Organisation gegen Kindesmissbrauch in den USA gemeldet wird, sind Bilder, die mit PhotoDNA Technologie (also HASH) Erkennung identifiziert werden. Von bekannten Kinderpornografischen Bildern gibt es schon seit über 10 Jahren eine Datenbank. Dort wird der HASH des Bildes eingetragen. Taucht dieser HASH auf, wird es gemeldet. Microsoft und Google (liebe Andorid User) machen es schon seit Jahren (siehe auch: https://blog.google/outreach-initiatives/google-org/our-continued-commitment-to-combating/) von 2008.

Was jetzt hier neu ist, dass es auf IOS Geräten nun auch lokal abläuft, also ohne Upload in die iCloud.

Niemand hat zufällig solche, in dieser Datenbank eingetragene Bilder, zufällig auf seinem Handy.

2) Gibt es nun eine Erkennung von angeblich Pornografischen Bildern in der IOS Message APP. Diese KI schaut sich tatsächlich die Bilder an, welche an ein KIND über Message geschickt werden oder welches ein Kind über Message verschicken will.

Blurrt dieses Bild bei vermutlicher Erkennung und informiert die Eltern (nicht die CIA, nich die NSA, nicht die Polizei!) Da kann man dann persönlich entscheiden: Fehlalarm, es ist ne Banane oder Ja, ein Treffer und dann man kann sogar immer noch entscheiden ob das Kind Pornobilder sehen darf oder nicht.

3) Bilder, die man selber mit dem iPhone macht, werden nicht geprüft.

Also mal wieder viel Lärm von Leuten, die nicht lesen und/oder verstehen können.

Weil von Hash bis zur Überwachung nur ein kleiner Schritt ist. Apple hat schon gute Prozesse zur Mustererkennung (hier: Gesichter) und kann es problemlos ausweiten. Dann mit einem anderen Prozess verknüpfen und schon haben wir die Überwachung …

Der vernünftigste und schlüssigste Beitrag in diesem Chat. Es erfreut mich immer wieder, dass es auch noch intelligente Menschen gibt!

@cypher72

Danke, endlich mal einer der es verstanden und sehr gut erklärt hat.

.++++

Wenn ich die Technik richtig verstehe, dann werden von bereits bekannten kinderpornografischen Fotos Hashs generiert, die dann mit anderen Hashs abgeglichen werden. So funktionieren beispielsweise jetzt schon OneDrive und Google Drive. Wie gesagt: Kontext. Apple ist hier kein Pionier, sondern Nachzügler. Also passiert das sicherlich auch schon beim Upload in die iCloud (was ja praktisch der Standard ist). Das ist übrigens auch die Funktion wie YouTube lizensiertes Material erkennt, weswegen manche Sachen gespiegelt / gedreht / gefiltert hochgeladen werden, weil dadurch neue Hashs erzeugt werden und der Mechanismus nicht so schnell anschlägt.

Alarmierend ist, dass das nun auch scheinbar lokal passiert und bei angeblich Ende-zu-Ende verschlüsselter Kommunikation. Ggf. irgendwann um die Komponente AI erweitert. Im Allgemeinen gruselig, was damit dann alles möglich ist. Im Irak eine Regenboggenflagge fotografiert: Kopf ab. In China ein politisches Graffiti fotografiert: Arbeitslager.

Es gibt bestimmt Möglichkeiten gezielt Verbindungen zu den Servern zu unterbinden, aber dazu braucht man technisches Know-How und bewegt sich immer mehr in einen Graubereich und macht sich immer verdächtiger.

@Thomas: Eigentlich muss man doch nur den Foto Upload in die Cloud deaktivieren. Die Bilder werden laut Apple dann nicht überprüft.

Also komme ich bald in den Knast wenn ich die frische Banane auf dem Markt fotografiere und meiner Frau schicke? =(

Wenn das Bild in der Datenbank von Kinderpornografischen Material ist, ja.

Kommt natürlich auf die Größe der Banane an….

Dein soziales Verhalten wird ab sofort beeugt. Als gib Acht Tutti-Frutti :)

Es ist abscheulich, wenn Kinder sexuell missbraucht werden. Dennoch, dass was Apple hier macht, ist Bevormundung. Auch wenn’s „nur“ ein Algorithmus ist, der meine Photos durchsucht – seit wann ist ein Techunternehmen für den Inhalt eines Privatgerätes verantwortlich und zuständig? Bei Serverinhalten ist das klar- bei Privatgeräten? Meine Meinung – wie schon weiter oben erklärt: bei gewissen Staaten wird es mehr Begehrlichkeiten geben, als der sinnvolle Schutz von Kindern.. das geht hierbei in die falsche Richtung..

Nein, nicht nur per Algorithmus. Hat der Algorithmus angeschlagen werden die Daten manuell ausgewertet. Man möchte Fehler vermeiden die passieren können.

Es geht um Fotos, die mit iCloud abgeglichen werden – also am Server liegen. Jetzt werden die schon am Server durchsucht. So können die dann am Server verschlüsselt abgelegt werden und nur mehr lokal mit einer Datenbank abgeglichen.

Weil hier gleich wieder mit technischem Halbwissen geglänzt wird, eine kurze Ergänzung.

Oben beschrieben sind zwei Technologien, die augenscheinlich Ähnliches Tun aber komplett unterschiedlich funktionieren:

Die Erkennung in iMessage läuft über Apples Bild erkennungs Algorithmen, wie sie das iPhone schon in Fotos drin hat.

Die KiPo Erkennung in der Bildermediathek läuft anhand von Bild-Hashes und basiert auf einer Technologie die von Microsoft entwickelt wurde um aus Bildern einen eindeutigen hash zu generieren, auch wenn Ausschnitt und Auflösung geändert werden. Dabei lassen sich aus einem Hash keine Rückschlüsse auf ein Bild ziehen, es sei denn das Bild ist schon bekannt. Damit passiert das gleiche, wie schon jetzt beim upload von Bildern auf One-Drive, Dropbox, Google-Drive etc. aus Bildern wird anhand eines Algorithmus ein Hash gebildet, und dieser gegen die Datenbank bekannter hashes verglichen. Falsch Positive Erkennungen sind theoretisch denkbar. Wie bei jedem Hash verfahren kann es zu kollisionen kommen. Diese sind aber äußerst unwahrscheinlich. Eine Meldung erfolgt auch nur, wenn es zu einer starken Häufung kommt.

Dabei läuft die Prüfung in der Mediathek nicht anhand von Bilderkennung. Und es gibt kein Verfahren um Hash Kollisionen komplett auszuschließen. Es wäre also theoretisch möglich dass ein Bild von einem Auto zufällig den gleichen Hash generiert, wie eines, dass auf der „verbotenen Liste“ steht.

Danke, für die Erläuterungen. Es ist eben, wie so oft, kompliziert da komplex. Bauchgefühle erscheinen auch in diesem Fall als Argument ungeeignet.

Das ist doch vollkommen egal was für Technologien. Das hat nicht auf Geräten der Nutzer stattzufinden. Punkt. Dafür gibt es Polizei, und bei Verdacht Richter, die alles mögliche anordnen und erlauben können. Aber prophylaktisches Durchleuchten, das geht überhaupt nicht. Die Verhaltensänderung muss über gesellschaftliche Strukturen gehen, das muss noch viel deutlicher geächtet werden. Wir sehen ja was in der Kirche los ist. Wer durchleuchtet jetzt die Kirche prophylaktisch? Ich halte das Vorgehen von Apple für absolut unzumutbar und indiskutabel.

Das unzumutbare machen andere Konzerne schon länger und es ist zumutbar.

Ich finde es völlig zumutbar und nicht in Ordnung, wenn Du BEKANNTE Kinderpornos auf Deinem Handy bzw. in Deiner Cloud hättest.

Keinen interessiert das Foto Deiner nackten Frau oder das Nackedeibild deines Kindes!

Nur SCHON BEKANNTE Kinderpornos werden gefunden!

Bei reinen Hash-Werten stimme ich dir zu, da gibt es so gut wie keine Fehlinterpretationen.

Was aber PhotoDNA angeht, da sind die Fehlinterpretationen schon weitaus häufiger. Da wird sich noch so mancher wundern, wenn die Maschinerie loslegt und sämtliche IT erstmal sichergestellt und durchleuchtet wird.

Das sehe ich leider auch kommen. Hier gibt es vor allem massive gesellschaftliche Probleme zu beachten. Wenn die Nachbarn mitbekommen das jemand wegen KiPo durchsucht wurde, selbst wenn das vollkommen unbegründet war, ist die Person erledigt. Der Freundeskreis wird ebenfalls seine Konsequenzen ziehen.

Was aber noch viel schlimmer ist, ist die Nutzbarkeit dieser Situation. Wenn das komplette digitale Leben von Behörden kopiert und durchsucht wird, ist das wie ein Atomschlag in die Privatsphäre. Selbst wenn das unbegründet war, ist die betroffene Person in einem Maß untersucht worden, der in keinem Verhältnis zum eigentlich Zweck mehr steht. Die digitalen Inhalte gehen teilweise jahrzehnte zurück, was da alles an „nützlichen“ Zusatzinfos erfasst und analysiert wird, ist absolut inakzeptabel. Und keiner kann mir sagen, dass Behörden das nicht ausnutzen würden und das ganze bei der Gelegenheit gleich auf alle erdenklichen anderen Zwecke anwenden und für immer speichern.

Dieser Anwendungsfall findet aber nur bei iMessage anwendung und informiert die Eltern. Die müssen dann entscheiden welche drastischen Maßnahmen sie ergreifen.

… du vergißt allerdings, dass iOS schon eine sehr gute Gesichtserkennung dabei hat. Diese zu „erweitern“ und nach anderen Mustern zu suchen dürfte recht leicht sein. Dann das bestehende Flag setzen und zurückmelden und bumms, schon ist der Account gelockt.

Was ein Blödsinn. Als würde das die Kids heutzutage davon abhalten sich das Bild anzusehen. Die Neugier des Menschen ist nunmal größer. Das ist genauso wie dem Beispiel des roten Knopfs den der Mensch auf keinen Fall, niemals drücken soll. Warum? Klick. Oh. Wo ist also genau der Schutz? Unter dem Begriff ist ja vieles zu verstehen, nicht nur Dickpics. Spätestens um zu wissen was denn der Versender geschickt hat, wird man sich das Bild ansehen. Und am Ende ist es ein Hund aus der Vogelperpektive fotografiert der den Umriss eines Penis darstellt. Was haben wir gelacht. Kann Apple eigentlich auch bis drei zählen? Auch die Durchforstung der Fotomediathek meiner Kinder geht Apple nix an. Wenn mein Sohn sich bei intimen Aktivitäten fotografiert und dabei minderjährig ist hat das Apple nichts anzugehen und schon gar nicht darf das Bild näher beleuchtet werden um am Ende auf einem Verdachtsfall bei irgendeinem menschlichen Prüfer landen der munter seine Bibliothek füllt. Wo kommen wir da hin? Wie war das nochmal letztens mit dem Richter der sich aus Fallakten die Bilder der Kinder selbst gezogen hat? Es gibt immer diesen Einen der aus sowas seine Vorteil zieht. Apple soll sich aus solchen sensiblen Themen einfach raushalten. Wenn sie dem ganzen soviel Energie zuwenden wie dem AppStore, Homekit, Siri & Co, sehe ich schwarz.

Die Warnung, dass die Eltern einen Hinweis erhalten, sollte durchaus ein gewisses Abschreckungspotential haben. Setzt natürlich Medienkompetenz bei den Eltern voraus, dass sie die Familienfreigabe auch entsprechend aktiviert haben.

Die Warnung führt lediglich dazu den Messaging Dienst zu wechseln, jeder von uns war mal Kind und weiß das man mehr oder minder schlau genug war die Eltern auszutricksen.

Wie auch immer ob komplett anonym oder rüber nicht. Es wird durchsucht und durchleuchtet. Bei Kindern kann man schwer gegen reden ohne gleich als Täter dar zu stehen. Doch so kommt es in Zukunft in immer mehr Bereiche. Als Nächstes terror dann allgemeine Kriminalität und zum Schluss zum zu sehen wie du generell so denkst.

Ja Text hat Fehler ist mir aber egal, da auf dem Pott ;D

Pfui

Also so wie ich das lese läuft die Prüfung aber in jedem Fall grundsätzlich lokal ab und nicht bei Apple und hat nur zur Folge das ich erstmal eine Warnung bekomme bevor ich das Abbild sehe und die Information verlässt nicht mein Gerät?

Lediglich wenn ich die Familienfreigabe aktiviert hab und es als KinderIPhone aktiviert hab geht zusätzlich eine Warnung an die Eltern-IPhones?

Aber weder Apple noch sonst jemand wird darüber informiert, korrekt?

Wenn das so stimmt fände ich das super umgesetzt!

Genau so… die Bildanalyse ist dieselbe, die jetzt auch schon lokal nach Gesichtern und Schlagworten sucht. Dieser Algorithmus wird lediglich entsprechend erweitert.

Kinder nackt zu Fotografieren ist einfach nicht normal…

Hab ich nie verstanden wieso Eltern das machen.

Passiert schnell. Ist uns auch schon passiert beim Baden des Babys. Solche Fotos würd ich allerdings auch dann nicht verschicken

Da gebe ich dir recht . Versenden niemals !

Weil das einfach so ist am Strand oder ähnlich wenn noch sehr klein. Hat früher keinen gestört weil normal. Heute ist Alles verwerflich

Ach ? Das ist nicht normal ? wie spielt denn dein zweijähriges Kind am Stand? Wie badet dein Kind in der Wanne? Vollverhüllt? Wo beginnt bei dir Nacktheit?

Wer hat nicht selber von seinen Eltern gemachte peinliche Bilder aus der Vergangenheit?

Wieso hat man am strand oder in der wanne die kamera am start?

Klar … du bist kein Elternteil, gell?

Nö, wieso ist es dann normal alle Hemmungen fallen zu lassen?

Geht mir ift genug auf den sack wenn ich bilder in den Familien oder freundesgruppen bekomme wo die Kinder nackig sind.

War zuletzt Wattwandern und hatte mein iPhone dabei, so wie nahezu alle Menschen dort. Ist eben ein schönes Naturschauspiel das man gerne festhalten will.

Am Strand waren auch im Matsch spielende Kinder mit ihren Eltern. Sorry, aber da schaut man dann einfach nicht hin und kümmert sich um seinen eigenen Kram.

Wieso verspüren einige immer den Drang, sich in anderer Menschen Angelegenheiten einmischen zu müssen?

@R4inb0wD4sh bin voll deiner Meinung.

Am Strand soll man keine Fotos seiner eigenen Kinder machen? Ernsthaft?

Was bist du denn für einer ? Am Strand keine Kamera ? Das erste mal Baden des Babys in der Wanne ? Quatschbilder aus der Wanne mit Schaum auf dem Kopf ? Es gibt soviele Situationen für später zu bewahren und festzuhalten. Ich glaube ehrlich du verwechselst da was oder willst mit Absicht einen Gegenpart ausüben um zu provozieren

Was für ein Blödsinn… natürlich machen Eltern Fotos von ihren Kindern … und je kleiner die sind, desto weniger haben die halt an. Es geht darum, ob die lieben Kleinen in eindeutigen Posen posieren oder ob das einfach nur ein nettes Bild ist. Und ja, man durchaus so fotografieren, dass man nun nicht unbedingt jedes primäre Geschlechtsorgan in Großformat abbildet.

Ich mache mir eher Sorgen um Leute, die schon aus möglichem Selbstschutz heraus solche Gedanken entwickeln und das alles verbieten lassen wollen. Da sprechen doch schon latente Gedanken raus.

Ich als Vater würde da nie im Leben solche Gedanken haben. Da hat die Natur einen Riegel vorgeschoben wie bei Geschwister. Da überwiegt Oxytocin und Serotonin eindeutig vor Phenylethylamin.

Wer beim Ansehen von kleinen Kindern aber eine Ausschüttung von Phenylethylamin erlebt, der würde das vielleicht auch eher verbieten wollen :-/

Also ich fotografiere keine Kinder nackt, egal wo…

Es ist einfach seltsam… und das fand ich schon immer.

Ich fotografiere ja auch am FKK Strand keine nackten Leute…

Weil das einfach seltsam ist.

Da ist weder etwas süß noch erhaltenswert, wenn kleine Kinder nackt sind.

Es gibt Badehosen und auch Badeanzüge für Kinder.

Das schreibe ich nicht um zu provozieren, sondern einfach weil ich es nicht verstehen kann, wieso Kinder unbedingt Nackt fotografiert werden müssen.

Wenn ich Kinderbilder in Familienalben sehe, wundere ich mich jedes Mal, wieso da nackte Kinder rein gehören.

Ehrlich gesagt finde ich es schon sehr abartig, wenn man kleine Kinder mit deren Genitalien Fotografieren muss…

Dabei ist auch völlig egal, wie du das Chemisch und Hormonell erklärst…

Wer keine pornografischen Bilder von Kindern macht, braucht sich auch keine Sorgen machen…

Deine Argumentation, das was mit einem nicht stimmen könnte, weil man nicht auf Kinderbilder ohne Klamotten steht habe ich hoffentlich falsch verstanden.

Ich hab einfach keinerlei Interesse an kleinen Kindergenitalien, da kannst du nichts dran drehen.

Und das ist der „moralische“ Punkt. Was ist „pornografisch“? Wenn du keine Interesse hast, dann ist auch alles okay. Wenn du es nicht postest dann ist es richtig. Die Intension dahinter ist entscheidend.

Meine Tochter auf dem Bauch liegend im Sand mit dem Eis in der Hand ein tolles Familienfoto (für die eigene Familie – die Personen um mich herum, nichts für den Onkel oder weiter entfernt). Ein Bild von ihr, wie sie das runterlaufende Eis von den Beinen leckt und … Nope! No Go! So was ist unter aller Kanone und keinen Kommentar wert! Selbst in der Familensammlung!

Naja ich sag Ma so, iMessage nutzen eh je die wenigsten.

Mag sein. Aber das wird durch die EU Verordnung zwangsläufig auf jeden Messenger sich ausbreiten.

In den USA sieht das anders aus.

Wird sicher so akzeptiert, weil für eine gute Sache!

Aber wo ist der Anfang und wo das Ende? Bekommt am Ende jeder Mikrofon und Kamera in die Bude gehängt? Natürlich auch nur für eine gute Sache. Z.B. um schnell helfen zu können, wenn man einen Schlaganfall bekommt oder von einen bösen Buben überfallen wird…. ;-)

Ich sehe das alles sehr sehr kritisch!

Mit dem ersten Glied ist die Kette geschmiedet….

Was mit guten Absichten beginnt, kann schnell fatal enden

Da entwickelt sich Apple irgendwie in die vollkommen falsche Richtung. Nun wird man also von seinem iPhone gewarnt, wenn man mit dem Partner mal leicht bekleidete Bilder austauschen sollte….Super Apple :D

Am besten noch mit der selben Warnung, dass das Bestätigen an deine Eltern weitergeleitet wird ;)

Das Feature ist doch nur bei Kinder Accounts aktiv.

Zum lokalen Scannen der Fotos:

Die EFF beschreibt in dem oben genannten Link allerdings, dass nur Fotos, die zur iCloud hochgeladen werden, geprüft werden. Hat sie da schlecht recherchiert oder ist hier ein Fehler passiert?

Das hab ich gestern im Artikel auch schon bemängelt. Es werden – außer bei der iMessage-Sache – keine Fotos „gescannt“, die in der lokalen Mediathek liegen (wenn iCloud Fotos deaktiviert ist und iCloud Backup auch),

Neu ist, dass die iCloud Fotos mit einem Prozess lokal auf dem iPhone gescannt werden, bevor sie hochgeladen werden. @nicolas

Noch einfacher: Hat man iCloud Fotos und iCloud Backup deaktiviert, passiert gar nichts. Schaltet man eins davon ein, werden Bilder beim Upload in iCloud Fotos oder beim iCloud Backup mit den Werten gegengeprüft.

Ich habe das so verstehen, das es jetzt auch lokal auf dem iPhone gescannt wird und nicht nur in der Cloud

Na super, Apple, da hast Du manchen Diktator auf eine gute Idee gebracht!

Ist doch klar, dass China morgen eine Liste mit „unerwünschten“ Fotos erstellt (Tank man) deren hash Apple dann auch filtern muss.

Übermorgen kommen Texte dran und danach wird das gesamte iPhone auf „kritische“ Inhalte gescannt. Wird per Gesetz vorgeschrieben, kann Apple nichts gegen machen.

Und den bösen winnie pooh werden die chinesen auch in die datenbank aufnehmen, wird aber dann zu vielen falsch positiv alarmen kommen wenn die leute Fotos von dem präsidenten haben

Nächster Schritt dann automatisiertes melden Andeutungen mutmaßlicher Straftaten.

Minority Report lässt grüssen.

Grund zu Android zu wechseln, aber da weiß man gar nicht was die mit deinen Daten machen.

Vieles was Apple macht findet schnell eine Nachahmer in Google & Co und anders herum. Also kannst drauf wetten …

WhatsApp möchte gerne die verschlüsselten Mitteilungen via KI „mitlesen“. Da ist ein Fork für Bilder schnell mit dabei …

Sehr gut! Und gerade habe ich online gelesen, dass WhatsApp wohl auch so etwas entwickelt.

Wenn Du so etwas liest, machst Du Dich verdächtig…

Weil er Nachrichten über WhatsApp liest? LOL

Wenn irgendwann der „WhatsApp Afrikaner“ gefiltert wird, was soll meine Frau dann ihren Freundinnen schicken?

Heute lachen wir noch über Chinas „Social Credit Point“ System, aber ich glaube wir bewegen uns genau in die gleiche Richtung, nur etwas eleganter. Uns dreht man den Kram noch mit einem „Mehrwert“ an. So dass wir das auch wollen. Vorwände wie Sicherheit, Terrorismus und Kinderschutz sind immer für alles gut. Da kann einfach keiner nein sagen.

Nach der Bildkontrolle, kommt definitiv auch die Textkontrolle. Und danach die Verhaltenskontrolle. Die Gesichtserkennung im iPhone sollte hier gute Dienste leisten.

Schon mal was von Schufa gehört? Wenn das kein Social scoring ist dann weiß ich auch nicht.

Und ist es schon Überwachung oder einfach nur praktischerweise alles dokumentiert und nachvollziehbar sobald jemand in die Akte guckt?

Dein Auto? Hat eine Lizenz und für alle sichtbare Kennnummer die auf jeder Kamera getrackt wird.

Autofahren? Hast du einen „Passport“ für. Biometrische Daten + Fingerabdruck? Ist auf deinem Ausweis.

Handy? Wird über Mobilfunkmasten geortet, selbst wenn es aus ist. (Dazu brauch es nichtmal ein Smartphone oder Apples neues Suchen feature).

Handyvertrag hast du natürlich mit deinem Namen und Adresse abgeschlossen, und wenn es Prepaid ist wahrscheinlich mit deinem Konto bezahlt, dass du mit deiner Identität und Wohnort verknüpft hast.Du bist in Deutschland meldepflichtig, soll heissen egal wo du hinziehst, du musst es dem Staat melden. Ausweispflicht? Yep. Vorratsdatenspeicherung? Yep.

Wir sind im Grunde schon da.

Ich fühle mich jetzt aber benachteiligt:

Diesen Filter einfach nur bei DickPics aktiv zu schalten…

Was ist denn wenn ich ein PussyPic bekomme? Da greift das dann nicht?

*IronieOff ;-)

wo ist den mein Beitrag hin – gelöscht vorhin waren hier über 130 Beiträge und jetzt nur noch knapp über 80 ?

ups sorry hab mich im Beitrag vertan kann gelöscht werden

Nicht Apple ist der Böse sondern die EU siehe Ausnahmeregelung für die E-Privacy-Verordnung (2002/58/EG).

aber das hätte auch in dem Bericht von IFun stehen müssen

Brustwarzen Alarm, super Idee ….

Kann ich den jetzt noch Bilder der Bezos Rakete verschicken?

Warnt iOS 15 denn auch vor Mumu Bildern?

Es wird nicht lange dauern, bis die ersten FunPics, die Millionenfach über WhatsApp verteilt werden, mit unsichtbaren Kinderporno Hashes versehen werden und so massenhaft zu falsch-positiv Meldungen führen werden…

Na zum Glück ist meiner so riesig dass ein Bildscan denkt es ist ein Baseballschläger.