Aktivierung ungewiss

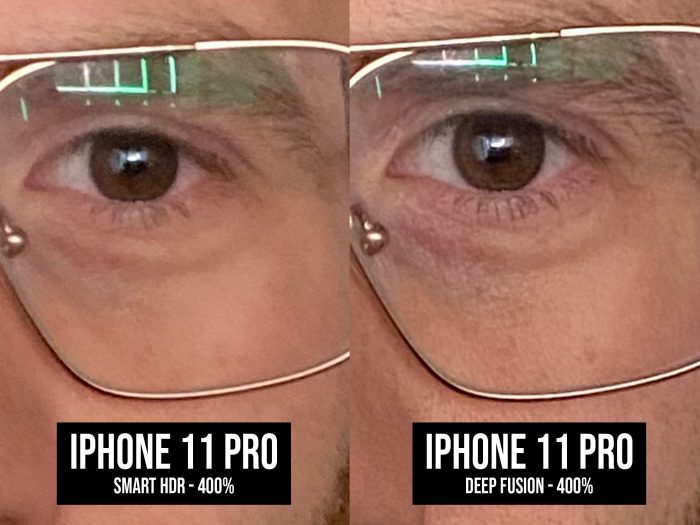

Deep Fusion: Die ersten Fotos sind vor allem schärfer

Für Apples neue „Deep Fusion“-Fotofunktion, die sich erstmals in der kürzlich veröffentlichten, ersten Beta von iOS 13.2 ausprobieren lässt, existiert leider (noch) kein Indikator.

Very first tests of #DeepFusion on the #iPhone11 pic.twitter.com/TbdhvgJFB2

— Tyler Stalman (@stalman) October 2, 2019

Entsprechend unmöglich ist es, die von maschinenlernenden Konzepten gestützte Fotoverbesserung jenen Bildern gegenüberzustellen, in denen Deep Fusion noch nicht aktiv war. Hier muss geraten bzw. mit der Lupe verglichen werden.

Zwar lässt sich etwas tricksen: Wer etwa iOS 13.1.2 nutzt oder auch die „Aufnahme außerhalb des Kamerarahmens“ aktiviert, kann sicher sein, dass die „Deep Fusion“-Funktion nicht einsetzt.

Andersrum gibt es jedoch keine Garantie, wie sich ein Foto anfertigen lässt, bei dem Apples „Deep Fusion“-Fotofunktion mit hundertprozentiger Wahrscheinlichkeit Anwendung findet. Entsprechend zaghaft fallen die ersten Foto-Vergleiche aus, die gerade ihren Weg ins Netz finden.

Was die Bilder jedoch alle miteinander gemein haben: Die Deep Fusion-Schnappschüsse sehen allesamt deutlich schärfer aus. Die finale Beurteilung überlassen wir jedoch euch.

Wow ja, unheimlicher Unterschied… ist bestimmt geil für die, die den Unterschied zwischen 5K und 8K angeblich sehen.

Mal ehrlich, sieh dir die Bilder auf einem Monitor an und sag mir du erkennst den Unterschied nicht…

Dann brauchst du auch eine Brille… wollte es auch lange nicht wahr haben.

@all: Ja Hauptsache beleidigen ;)

eine brille zu tragen, ist nichts abwertendes. oder muss ich mich jetzt mies fühlen?

@george: Wenn du dich jetzt beleidigt fühlst, dann kann man dir leider nicht mehr viel helfen.

@tomas. Es geht um die Art, wie es hier rübergebracht wurde ;)

@Nimo, ich dachte beleidigt wegen jedem Mist sein, ist salonfähig.

Ganz ehrlich? Ich finde die Unterschiede sind deutlich zu erkennen :)

Ich auch, weiß echt net wie man das net erkennen kann

Kommt halt immer auch auf den Bildschirm und das Bildmaterial an…

Ja deutlich zu erkennen bei X facher vergößerung, sonst nicht.

Also ich hab es in der app auf dem Handy (6s Plus) angeschaut und grade das Bild mit der Brille sieht man sehr gut den Unterschied

Ich glaube ihr habt nicht kapiert dass das nur Bildausschnitte sind. In Originalgröße sieht man da gar nichts.

Wenn man Blind ist sicher nicht. Ansonsten schon.

ich finde die Unterschiede sind schon sehr deutlich und klar zu erkennen. weis zwar nicht warum du es nicht siehst, aber vielleicht dich mal ne Brille aufsetzen als Tip. :-)

Das könnte ggf. der Tod der kleineren und bis dato besseren Kompaktkameras werden. Und sogar die Qualität der Ausdrucke im Postkartenformat sind dadurch schon wesentlich besser.

Jaa da hast Du Recht, Postkartenformat. Mach mal ein A2 Foto Ausdruck. Hihi

Die Farben in DeepFusion gegenüber dem Alten. Schreklich. Ja man sieht den Unterschied.

@Random Farben? Die sind doch in beiden Bildern gleich.

Den Unterschied zwischen 5 und 8K? Kommt ganz auf die Größe des Displays an! Das Zauberwort heißt hier PPI und selbst da erkennen einige Leute deutlich mehr als andere. Beim Gehör ist es genau so.

Das sind dann genau die Blindschleichen, die den Unterschied zwischen SD und 4K nicht sehen..

Oder die die 70Hz und 144Hz..

120Hz und 144Hz nicht unterscheiden können.

Die sollten mal paar Ärzte besuchen..

Aha, da ist die Beleidigung wieder :)

Was hat denn das eine mit dem anderen zu tun? Klar sieht man einen Unterschied zwischen 5k und 8k, ist alles eine Frage der Skalierung. Die Auflösung hat absolut keine Aussagekraft ohne im Verhältnis zur Bildgrösse und Entfernung zu stehen. Besser ist da ppi, aber selbst dann fehlt noch die Komponente Entfernung.

Bist du blind? Oder siehst du die Unterschiede wirklich nicht??

In der 1. Beta von iOS 13.2 auf meinem iPhone 11 Pro sind die Fotos etwas schärfer, aber leider auch deutlich zu weich gezeichnet. Gesichter sind viel zu glatt, Falten und die Augen alle weggezeichnet.

Das wird aber sicher in den nächsten Betas besser.

Es gibt auch schon Vergleichvideos auf Youtube, ist schon wahnsinn, was die Technik nochmal aus den Bildern rausholt. Freue mich schon auf die Finale Version.

Wow amazing dieser Unterschied jetzt muss ich mir das Pro holen!!!

Wieso?

Deep Fusion geht auch mit dem iPhone 11 (ohne Pro)…

Ich finde die linken Bilder teilweise sogar besser.

Ja klar, wenn man auf unscharfe Bilder steht

Ich sehe keinen Unterschied zwischen den Bildern. Außer bei den Makroaufnahmen.

Teilweise sind die Deep Fusion Bilder ja auch links. Ist zugegebenermaßen etwas verwirrend.

Irgendwie ist euer Artikel etwas widersprüchlich, einerseits schreibt ihr, es sei nicht ganz klar, wann die Funktion Anwendung findet und dann schreibt ihr. Bei folgenden Fotos wurde Deep Fusion angewendet …

oder versteh ich das falsch.

Wie dem auch sei, finde Apple hatte hier ein Info einblenden sollen „Deep Fusion aktiv“ oder verfügbar, sodass man beim Fotografieren auch darauf achten kann oder es aktiv einschalten kann.

Was Dir Bilder betriff finde ich den Unterschied massiv

Vor allem was das Portrait oder selfie anbetrifft wenn man ihm näher ins Gesicht schaut oder das einzelne Haar auf der Stirn betrachtet !

Genial

Ich finde beide gleich schlimm.

Ich finde den Unterschied auch gut sichtbar. Jedoch würde mich interessieren, wie viel größer die Bilddateien dadurch werfen. Gleich doppelt so viele MB?

Ich finde es auch besser!

Das sind doch wieder nur softwareseitige Spielereien, die mit verbesserter Fototechnik nichts zu tun haben.

Macht endlich die Linsen größer um mehr Licht verarbeiten zu können!

Das wäre mal ein Fortschritt.

Hardware kann jeder. Software nicht. Apple kann’s.

Apple kann software….der war gut. Ios 13, mehr sag ich nicht…

Also Apple ist im Vergleich zu anderen Software- und Hardware-mäßig weit hinten dran… Schon vergessen, das Zwillinge das iPhone X des anderen entsperren konnten?

Zeig mir doch mal einen Handychip der es mit dem A13 aufnehmen kann!? Ach und wo du beim X einen Zwilling brauchst, kannst du das bei anderen mit einem Ausdruck entsperren.

@sailor

Wir reden von software. Hardware kann apple, keine frage. Aber bei der software könnten sie ruhig ein paar nachhilfestunden nehmen

@Simon Bei wem denn?

@Simon Bayraktar hat sich auf Soft.- und Hardware bezogen. Was Software angeht hatte ich bis auf Kleinigkeiten nie Probleme mit iOS oder MacOS.

@Sailor also bei mir hat der Portrait Modus Bühnenlicht/Bühnenlicht Mono noch kein einziges Mal so funktioniert, wie Apple es damals beworben hat.

Das sind Kompaktgeräte da spielt die Software eine große Rolle das Zusammenspiel macht es! Und Apple hat nun mal das beste von allen! Software und Hardware sind super! Da können sich andere Namenhaften Hersteller was abschauen. Ich kenne viele Seiten sehr gut aber es kommt keiner an die Applehardware ran.

Also ich finde desto besser die rohe Fotoqualität daher kommt, umso besser wird die nachträgliche Bearbeitung ermöglicht. Ich freue mich auf DF und finde scharfe Bilder viel interessanter, als dauerhaft weichgezeichnete Bilder. Das kann man im Nachhinein immer noch zaubern, aber die erste Qualität muss Detailreich stimmen.

die „Aufnahme außerhalb des Kamerarahmens“ aktiviert, kann sicher sein, dass die „Deep Fusion“-Funktion nicht einsetzt.

Das heißt also das ich die Funktion abgeschaltet lassen muss. Schade.

Ja. Das wäre wirklich schade. Finde die Funktion super.

Hier im Video mal ganz gut erklärt.

https://youtu.be/nDbkCYLuXLI

Danke, ich bette das mit ein oben.

Es heißt immer es gibt keinen Indikator ob Deep Fusion aktiviert ist oder nicht.

In der Keynote wurde doch gesagt es kämen 24MP Fotos dabei raus. Normal werden ja über alle Linsen 12MP Fotos erzeugt.

In der Fotos App sieht man das natürlich nicht. Aber die Fotodaten die ausgelesen werden können (bsp. am mac) sind doch dann eindeutig oder?

Die App Hydra hat doch eine ähnliche Funktion, kann man die Ergebnisse mal vergleichen?

Heil Hydra! ;)

Die Bildbetrachtung im Kameramodus im Querformat bei 13.2 ist defekt.

Für mich persönlich macht Apple ihre eigenen Produkte schlecht. Wer sich vor dem Apple Event ein iPhone XS Max mit 512 GB fur 1600 Euro gekauft hat, hat nun alten Schrott in der Hand. Wenn das nur Software ist wie oben dargestellt, dann stellt sich mir die Frage warum das iPhone X und neuer diese Funktion nicht auch erhalten.

Für mich heißt das, dass war das letzte iPhone.

Es ist nicht nur Software. Meines Wissens hat das 11er auch eine schnelle Anbindung der Kamera (Hardware), die es überhaupt erst ermöglicht, diese vielen einzelnen Fotos in Bruchteilen von Sekunden zu schießen. Ob der A13 Bionic für die Verarbeitung unbedingt notwendig ist, möchte ich nicht beurteilen, aber in jedem Fall ist er dafür optimiert.

Gerne darfst du deinen Schrott bei mir kostenlos entsorgen :)

machs gut Ich73 !

Wer kauft sich denn kurz vor dem Event die „alte“ Generation bei Apple, wenn man a) weiß dass die neue Generation vor der Haustür steht und b) es für die aktuelle Generation schon überall gute Rabatte gibt

Deep Fusion —> 24 MP Bild = größere Datei als die 12 MP Bilder ohne DF —> einfach am Mac die Dateigröße auslesen und schon hat man den Unterschied.

Ich sehe bei den Deep Fusion Bilder mehr Rauschen. Da fehlt noch die Feinabstimmung, denke ich. Aber schärfer sind sie, das stimmt.

Es gibt einen einfachen Weg um zu sehen, ob Deep Fusion verwendet wurde oder nicht!

Einfach Direkt nach Auslösen des Fotos auf die Miniaturansicht links unten gehen, woraufhin das angefertigte Foto angezeigt wird. Nun auf das Bild achten. Bei Verwendung von Deep Fusion gibt es einen Mikro-Ruckler und man sieht, dass das Bild danach schärfer ist. Wurde kein Deep Fusion verwendet, bleibt der Ruckler aus! ;-)

Schärfe & Deep Fusion: in manchen Fällen vielleicht zu viel des Guten. Nicht alles was machbar ist, ist brauchbar. Ich kenne das von Objektiven. Manche Leitz-Objektive zeichnen derartig faszinierend scharf, dass man eigentlich mehr sieht als beim normalen Schauen. Das ist dann der Moment, wo die Porträtierten oft erschrecken und die Bilder nicht mögen, auch wenn sie oft gar nicht nennen können woran es liegt. Ob das der normale User das später dann wirklich dringend braucht?