Hinweise im Code: Sprachgesteuerter Assistent im iOS 5 ?

Gerade nach unserem mit Vorfreude geschwängerten Artikel „Stimmerkennung und Sprach-Interaktion: Die Kirschen auf dem iOS 5-Kuchen“ hat uns die zur WWDC ausgebliebene Ankündigung einer überarbeiteten Spracherkennung im iOS 5 ziemlich enttäuscht. eMails im Laufen diktieren, eine Google-ähnliche Spracherkennung für System-Befehle und die Aussicht auf eine endlich mal fehlerfreie Rufnummern-Eingabe über das iPhone-Headset wären mehr als willkommene Ergänzungen zu den sonst vorgestellten iOS 5-Funktionen gewesen.

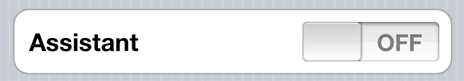

Möglicherweise zaubert Apple in Sachen Spracherkennung jedoch noch ein „One more Thing“ aus dem Hut. So finden sich in der aktuellen iOS Beta nun erstmals klare Hinweise auf die Systemweite Integration einen sprachaktivierten Assistenten. Die folgenden Textzeile im Code der iOS-Entwicklungsumgebung laden zu Spekulationen ein:

Der „Assistent“ nutzt Deine Spracheingabe und zusätzliche Informationen wie die Namen deiner Kontakte, Song-Titel und Positionsdaten um Deine Anfragen zu verstehen. Diese Daten werden zur Verarbeitung direkt zu Apple geschickt und helfen dabei Apples Produkte und Dienstleistungen zu verbessern.

Im April 2010 erwarb Apple das Startup „Siri“ (wir berichteten), eine kleine Software-Firma die bis dato nur ein Produkt lieferte: Einen persönlichen, komplett Sprachgesteuerten Assistenten – klingt uninteressant, kann und sollte jedoch in diesem Youtube-Video bestaunt werden.

Gespannt? Wir empfehlen die Abstecher zu diesen Artikeln:

- 29. März: Stimmerkennung und Sprach-Interaktion: Die Kirschen auf dem iOS 5-Kuchen

- 16. Mai : Konzeptvideo: Sprach-Interaktion im iOS 5

- 13. Juni : 200 neue Funktionen und ein stilles Extra? Die iOS 5-Spracherkennung lässt sich blicken

via macrumors

Sehr interessant ich mache mir heute die beta 3 drauf und dann delta update freu mich schon ( I LOVE APPLE )

Warum nicht gleich beta 4?

Das youtube-Video sieht echt gut aus, wenn das so optimal klappen sollte. Am beeindruckendsten fand ich die Kontexterkennung und die „Take me drunk I´m home“ Korrektur ;)

Es wird sicherlich in der Praxis nicht so gut funktionieren wie in dem Video, aber auf jeden Fall ein nice to have Ding ^^

Wie groß war der Aufschrei, als herauskam, dass Dragon Dictation das Adressbuch an einen Server schickt, um die Spracheingabe zu verbessern. Apple macht dasselbe + Musiksammlung etc., und es wird als bahnbrechendes Feature gefeiert.

…is halt Apple…da macht man das gern…;-)

Ja, ob es nun die „Musikgeschmackserkennung“ ist, oder das nichtvorhandensein einer konfigurierbaren Firewall, alles ziemlich besorgniserregend.

Is halt Apple, und auch da mach ich das ungern…

Wie der Originalartikel schon schreibt würde es mich überhaupt nicht wundern wenn das Feature iPhone 5 (und vielleicht noch iPad 2) exklusiv ist.

Nice, aber gibt es eigentlich auch schon heute. Schaut euch mal Dragon Search (gratis im App Store) an. Damit gehen die meisten Beispiele schon heute. Zugegeben das mit dem „betrunken nach hause“ Beispiel funktioniert so nicht, aber wenn man einfach »Taxi« sagt (bei eingeschalteter Ortungsfunktion der App) bekommt man ein vergleichbares Ergebnis.

Warum muss ich dabei an iButler denken?

Wäre das nicht eine coole Erweiterung?